OpenAI rafforza le politiche sulla sicurezza

Negli ultimi mesi, OpenAI ha fatto molto parlare di sé con l’introduzione dei nuovi modelli di intelligenza artificiale o1, una serie di algoritmi avanzati in grado di mostrare capacità di ragionamento mai viste prima. Tuttavia, la crescente curiosità degli utenti riguardo al funzionamento interno di questi modelli ha portato l’azienda a intervenire con decisione. Gli utenti che cercano di indagare più a fondo nel flusso di pensiero dei modelli o1 sono stati avvertiti della possibile violazione delle politiche di sicurezza, con conseguenze gravi, come il rischio di un ban dall’accesso ai modelli.

Il lancio della famiglia di modelli “Strawberry”

L’arrivo dei modelli o1 fa parte di un più ampio aggiornamento dei modelli di OpenAI, chiamato “Strawberry”, che ha suscitato notevole interesse. Questo nuovo set di algoritmi, incluso l’innovativo o1-preview, è progettato per risolvere problemi complessi attraverso una serie di passi logici che sembrano emulare il processo umano di ragionamento. Gli utenti possono osservare il flusso di pensiero filtrato che l’intelligenza artificiale segue per giungere alle sue risposte. Tuttavia, il vero ragionamento “grezzo” viene celato da un filtro gestito da un modello secondario.

La curiosità degli utenti e le prime violazioni

Quando qualcosa è nascosto o proibito, diventa inevitabilmente oggetto di grande interesse. Molti utenti di ChatGPT hanno cercato di aggirare le limitazioni imposte da OpenAI, nel tentativo di accedere al flusso di pensiero originale dei modelli o1. Alcune tecniche impiegate includono l’uso di comandi speciali o la creazione di contesti particolari per forzare l’intelligenza artificiale a rivelare il processo completo. Nonostante le difficoltà, alcuni sostengono di aver ottenuto informazioni parziali, ma nessuno può ancora confermare il successo di questi tentativi.

Le misure di sicurezza di OpenAI

L’azienda ha risposto rapidamente a queste azioni, inviando mail di avvertimento agli utenti coinvolti. Secondo OpenAI, cercare di esplorare il flusso di ragionamento dei modelli o1 rappresenta una violazione delle loro politiche sulla sicurezza e può portare a conseguenze serie, tra cui l’esclusione dall’accesso ai nuovi modelli. Alcuni utenti su X (precedentemente Twitter) hanno riportato di aver ricevuto questi avvisi anche solo per aver utilizzato termini come “traccia di ragionamento”.

La posizione di OpenAI: ragionamento filtrato per proteggere il modello

In una dichiarazione, OpenAI ha spiegato che il processo di ragionamento visibile all’utente è filtrato per evitare che informazioni sensibili sul funzionamento interno dell’algoritmo vengano esposte. Secondo l’azienda, la protezione del ragionamento grezzo è fondamentale per mantenere un vantaggio competitivo e impedire che altri sviluppatori utilizzino tali informazioni per creare modelli IA concorrenti.

Implicazioni per la comunità IA

L’azione di OpenAI solleva diverse domande per la comunità dell’intelligenza artificiale. Da un lato, gli utenti vogliono trasparenza, specialmente quando si tratta di modelli che influenzano decisioni complesse o delicate. Dall’altro, OpenAI deve bilanciare trasparenza e protezione del proprio business. Con la crescente competizione nel settore IA, aziende rivali potrebbero cercare di sfruttare ogni informazione trapelata.

I rischi della trasparenza: il dilemma etico

Rendere visibile il flusso di pensiero grezzo potrebbe avere ripercussioni significative non solo per la concorrenza, ma anche per l’uso etico delle IA. Se il flusso di ragionamento originale fosse accessibile, potrebbero emergere preoccupazioni circa bias algoritmici, errori di valutazione e altre problematiche che, se non adeguatamente filtrate, potrebbero influenzare negativamente gli utenti.

La minaccia di un ban: chi è a rischio?

Le mail di OpenAI non sono solo una semplice misura precauzionale. Gli utenti che insistono nel tentare di forzare il sistema potrebbero effettivamente essere bannati dall’accesso ai modelli o1. Questo include non solo sviluppatori curiosi, ma anche ricercatori e tecnologi che cercano di comprendere meglio le dinamiche del “pensiero” artificiale.

Politiche di elusione: un confine sottile

Le politiche di elusione della sicurezza di OpenAI sono state aggiornate per includere una serie di comportamenti che, fino a poco tempo fa, non erano nemmeno considerati una violazione. Utilizzare comandi o frasi che potrebbero indurre il modello a rivelare informazioni nascoste è ora considerato una pratica rischiosa.

Quali sono i limiti della trasparenza nei modelli IA?

Molti esperti del settore IA hanno espresso preoccupazione riguardo al concetto di trasparenza nei modelli come o1. Da una parte, la trasparenza potrebbe aiutare a ridurre l’incertezza sull’affidabilità delle IA. Dall’altra, come ha sottolineato OpenAI, la completa esposizione del flusso di ragionamento grezzo potrebbe portare a problemi di sicurezza e concorrenza.

Come la comunità IA sta reagendo alle restrizioni

Dopo l’annuncio di OpenAI, la comunità IA ha reagito in modi diversi. Alcuni ricercatori hanno espresso il loro disappunto per l’approccio restrittivo dell’azienda, sottolineando che l’accesso al ragionamento completo è fondamentale per comprendere e migliorare i modelli futuri. Altri, invece, comprendono le motivazioni di OpenAI, riconoscendo la necessità di proteggere la proprietà intellettuale in un ambiente competitivo.

Il rischio di limitazioni future per gli utenti

Con il tempo, è possibile che le politiche di OpenAI diventino ancora più stringenti. Gli utenti che cercano di sfruttare i modelli IA per scopi di ricerca o per migliorare le proprie capacità tecnologiche potrebbero trovare sempre più difficoltà ad accedere a funzionalità avanzate, specialmente se tentano di esplorare il flusso di pensiero nascosto.

Possibili sviluppi futuri per la trasparenza dei modelli IA

La questione della trasparenza nei modelli IA rimane aperta. Molti esperti credono che in futuro verranno sviluppati nuovi modelli di ragionamento che offriranno un compromesso tra trasparenza e protezione. Tuttavia, finché OpenAI rimarrà dominante nel settore, è probabile che le attuali restrizioni vengano mantenute per proteggere i propri interessi.

Conclusioni: OpenAI tra protezione e innovazione

L’avvertimento inviato da OpenAI agli utenti rappresenta un punto di svolta nella gestione dei modelli di intelligenza artificiale avanzati. Da una parte, la protezione del flusso di ragionamento grezzo è essenziale per mantenere un vantaggio competitivo. Dall’altra, questa decisione pone domande importanti sul futuro della trasparenza e dell’accessibilità nel campo dell’IA.

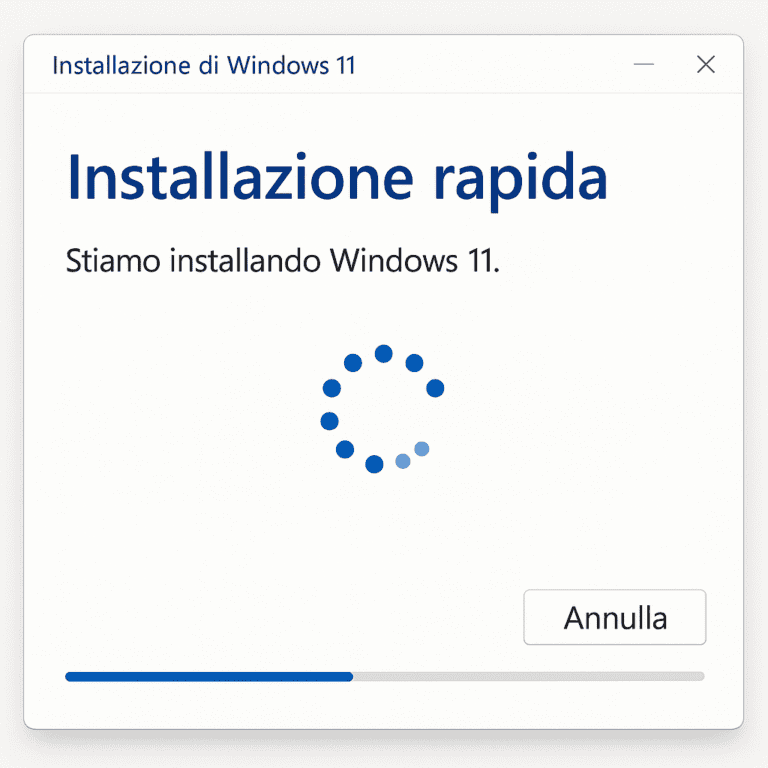

Tabella riassuntiva dei dati tecnici

| Modello IA | Funzione principale | Disponibilità pubblica | Protezione del flusso di pensiero |

|---|---|---|---|

| o1-preview | Risoluzione problemi | Sì, con limiti | Sì, filtrato da modello secondario |

| o1-mini | Elaborazione logica | Sì, con limiti | Sì, filtrato da modello secondario |